이미지와 텍스트를 함께 이해하고 연결하는 멀티모달 AI, CLIP의 모든 것!

CLIP(Contrastive Language-Image Pretraining)은 OpenAI에서 개발한 혁신적인 AI 모델로, 이미지와 텍스트를 동시에 이해하고 연결하는 능력을 갖추고 있습니다. 인터넷에서 수집된 4억 개 이상의 이미지-텍스트 쌍으로 학습된 CLIP은 다양한 분야에서 놀라운 성능을 보여주며, 이미지 인식, 검색, 생성 등 멀티모달 AI 연구의 새로운 지평을 열었습니다. 이 포스트에서는 CLIP의 핵심 개념, 작동 원리, 활용 분야, 그리고 한계점까지 깊이 있게 살펴보고, 궁금증을 해소해 드릴 예정입니다.

CLIP: 텍스트와 이미지의 만남, 멀티모달 AI의 탄생

CLIP은 텍스트와 이미지를 연결하는 멀티모달 AI 모델로, 기존의 컴퓨터 비전 모델의 한계를 뛰어넘는 획기적인 시도입니다. 기존 모델들은 이미지를 분류하기 위해 특정 라벨에 대한 학습이 필요했고, 새로운 라벨이 추가되면 다시 학습해야 하는 번거로움이 있었죠. 하지만 CLIP은 텍스트를 활용하여 이미지를 이해하고, 새로운 태스크에도 추가 학습 없이 성능을 발휘할 수 있습니다.

왜 텍스트를 활용할까요?

CLIP이 텍스트를 활용하는 이유는 크게 두 가지로 나눌 수 있습니다. 첫째, 텍스트는 이미지에 대한 풍부한 정보를 담고 있습니다. 예를 들어, "귀여운 강아지 사진"이라는 텍스트는 단순히 "강아지"라는 라벨보다 훨씬 더 많은 정보를 제공합니다. 강아지의 특징(귀여움), 이미지의 종류(사진) 등을 포함하고 있죠. 둘째, 텍스트는 이미지 라벨링에 비해 확장성이 뛰어납니다. 인터넷에는 이미지와 함께 다양한 텍스트 정보(설명, 제목, 태그 등)가 존재하며, 이를 활용하면 방대한 양의 데이터를 쉽게 확보할 수 있습니다.

CLIP의 핵심: 대조 학습(Contrastive Learning)

CLIP은 이미지와 텍스트를 연결하는 대조 학습(Contrastive Learning) 방식을 사용합니다. 이 방식은 이미지와 텍스트를 각각 인코딩하여 벡터 공간에 임베딩하고, 유사한 이미지와 텍스트는 가깝게, 다른 이미지와 텍스트는 멀리 위치하도록 학습합니다. 마치 이미지와 텍스트를 서로 비교하며 학습하는 것과 같죠.

예를 들어, "고양이 사진"이라는 텍스트와 고양이 사진이 입력되면, CLIP은 이 두 데이터가 서로 유사하다는 것을 학습합니다. 반면, "강아지 사진"이라는 텍스트와 고양이 사진이 입력되면, 이 두 데이터가 서로 다르다는 것을 학습하죠. 이 과정을 통해 CLIP은 이미지와 텍스트를 연결하는 멀티모달 임베딩 공간(Multimodal Embedding Space)을 학습합니다.

CLIP의 아키텍처: 이미지 인코더와 텍스트 인코더

CLIP은 크게 두 가지 주요 구성 요소로 이루어져 있습니다. 첫째는 이미지를 인코딩하는 이미지 인코더(Image Encoder)이고, 둘째는 텍스트를 인코딩하는 텍스트 인코더(Text Encoder)입니다.

이미지 인코더는 이미지를 입력받아 이미지의 특징을 추출하는 역할을 합니다. ResNet, ViT와 같은 다양한 컴퓨터 비전 모델을 사용할 수 있습니다. 텍스트 인코더는 텍스트를 입력받아 텍스트의 의미를 나타내는 벡터를 생성합니다. 주로 Transformer 모델을 사용하죠.

두 인코더는 각각 이미지와 텍스트를 멀티모달 임베딩 공간으로 변환하고, 이 공간에서 이미지와 텍스트의 유사성을 계산합니다. 유사성 계산을 위해 코사인 유사도를 사용하며, 학습 과정에서 이미지와 텍스트 간의 유사성을 최대화하고, 불일치하는 경우 유사성을 최소화하도록 학습합니다.

CLIP의 놀라운 활용 분야: 제로샷 학습의 마법

CLIP은 텍스트와 이미지를 연결하는 능력을 바탕으로 다양한 분야에서 활용될 수 있습니다. 특히 제로샷 학습(Zero-Shot Learning) 능력은 CLIP이 가진 가장 큰 장점 중 하나입니다. 제로샷 학습이란, 모델이 학습 과정에서 한 번도 보지 못한 새로운 태스크에 대해 추가적인 학습 없이도 성능을 발휘하는 것을 말합니다.

이미지 분류 및 검색

CLIP은 이미지를 분류하고 검색하는 데 유용합니다. 예를 들어, "고양이 사진"이라는 텍스트를 입력하면, CLIP은 고양이가 포함된 이미지를 찾아낼 수 있습니다. 이 기능은 이미지 검색 엔진, 이미지 분류 시스템 등에 활용될 수 있습니다.

객체 탐지

CLIP은 이미지에서 특정 객체를 탐지하는 데에도 사용될 수 있습니다. "빨간색 자동차"라는 텍스트를 입력하면, CLIP은 이미지에서 빨간색 자동차를 찾아낼 수 있습니다. 이 기능은 자율 주행 자동차, 로봇 비전 등에 활용될 수 있습니다.

이미지 생성

CLIP은 텍스트를 기반으로 이미지를 생성하는 데에도 사용될 수 있습니다. "푸른 바다와 하얀 모래사장"이라는 텍스트를 입력하면, CLIP은 이 텍스트에 해당하는 이미지를 생성할 수 있습니다. 이 기능은 이미지 생성 모델, 디자인 도구 등에 활용될 수 있습니다.

CLIP의 한계점: 넘어야 할 산

CLIP은 강력한 성능을 가진 모델이지만, 몇 가지 한계점을 가지고 있습니다.

복잡한 태스크에 대한 낮은 성능

CLIP은 제로샷 학습 능력이 뛰어나지만, 특정 복잡한 태스크에서는 여전히 낮은 성능을 보일 수 있습니다. 예를 들어, 의학 이미지 분석, 고해상도 이미지 분석 등과 같은 태스크에서는 추가적인 학습이 필요할 수 있습니다.

사회적 편향

CLIP은 인터넷에서 수집된 데이터로 학습되었기 때문에, 사회적 편향을 그대로 학습할 위험이 있습니다. 예를 들어, 특정 인종이나 성별에 대한 편견을 학습할 수 있으며, 이는 윤리적인 문제를 야기할 수 있습니다.

CLIP의 미래: 멀티모달 AI의 무한한 가능성

CLIP은 멀티모달 AI 연구에 새로운 가능성을 열어주었지만, 여전히 발전 가능성이 큰 모델입니다. 향후 CLIP은 더욱 다양한 분야에서 활용될 것으로 예상됩니다.

더욱 발전된 멀티모달 AI 모델 개발

CLIP은 텍스트와 이미지를 연결하는 능력을 갖추고 있지만, 향후에는 비디오, 오디오, 3D 데이터 등 다양한 모달리티를 연결하는 멀티모달 AI 모델이 개발될 것으로 예상됩니다.

인간과의 상호 작용 증진

CLIP은 인간과 컴퓨터 간의 상호 작용을 증진시키는 데에도 활용될 수 있습니다. 예를 들어, 이미지를 설명하는 챗봇, 이미지를 검색하는 음성 인식 시스템 등이 개발될 수 있습니다.

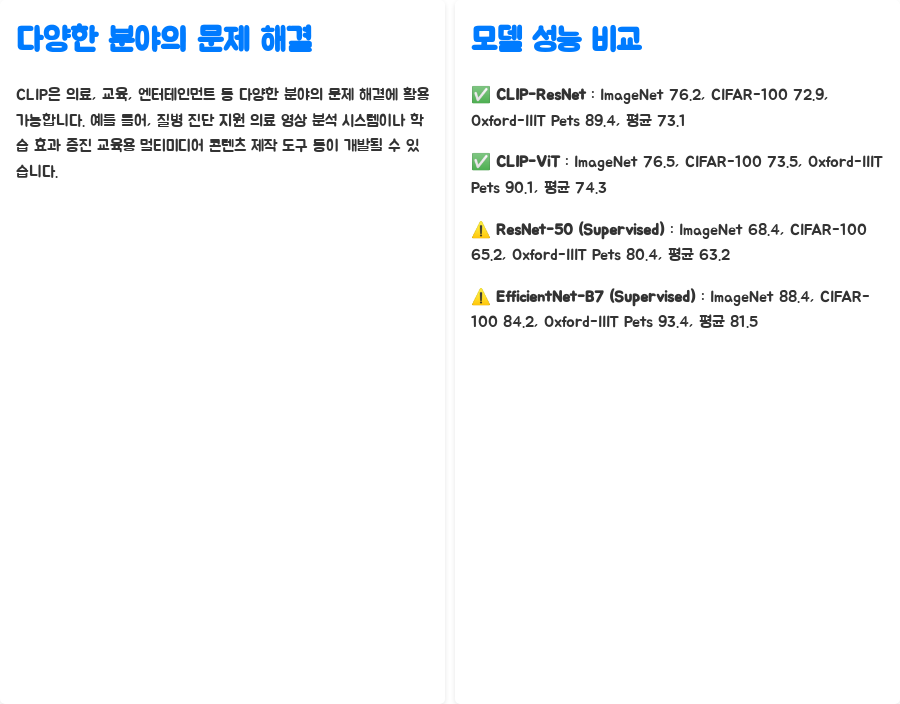

다양한 분야의 문제 해결

CLIP은 의료, 교육, 엔터테인먼트 등 다양한 분야의 문제를 해결하는 데에도 활용될 수 있습니다. 예를 들어, 질병 진단을 돕는 의료 영상 분석 시스템, 학습 효과를 높이는 교육용 멀티미디어 콘텐츠 제작 도구 등이 개발될 수 있습니다.

| CLIP-ResNet | 76.2 | 72.9 | 89.4 | ... | 73.1 |

| CLIP-ViT | 76.5 | 73.5 | 90.1 | ... | 74.3 |

| ResNet-50 (Supervised) | 68.4 | 65.2 | 80.4 | ... | 63.2 |

| EfficientNet-B7 (Supervised) | 88.4 | 84.2 | 93.4 | ... | 81.5 |

모델 ImageNet(Zero-shot) CIFAR-100(Zero-shot) Oxford-IIIT Pets (Zero-shot) ... Average

궁금증 해소: 자주 묻는 질문 (FAQ)

Q1. CLIP은 어떤 데이터를 사용하여 학습하나요?

A1. CLIP은 인터넷에서 수집된 4억 개 이상의 이미지-텍스트 쌍으로 학습되었습니다.

Q2. CLIP은 어떻게 이미지와 텍스트를 연결하나요?

A2. CLIP은 이미지와 텍스트를 각각 인코딩하여 벡터 공간에 임베딩하고, 유사한 이미지와 텍스트는 가깝게, 다른 이미지와 텍스트는 멀리 위치하도록 학습합니다.

Q3. CLIP의 제로샷 학습 능력이란 무엇인가요?

A3. CLIP의 제로샷 학습 능력은 모델이 학습 과정에서 한 번도 보지 못한 새로운 태스크에 대해 추가적인 학습 없이도 성능을 발휘하는 능력을 말합니다.

마무리

CLIP은 멀티모달 AI 분야에서 혁신적인 발전을 이룬 모델이며, 앞으로 더욱 다양한 분야에서 활용될 가능성이 높습니다. 이미지와 텍스트를 연결하는 CLIP의 능력은 인간과 컴퓨터의 상호 작용을 더욱 풍부하게 만들고, 다양한 문제를 해결하는 데 기여할 것입니다.

키워드

CLIP, 멀티모달, AI, 인공지능, 이미지인식, 텍스트, 제로샷학습, 컴퓨터비전, 머신러닝, 딥러닝, 오픈AI, 대조학습, 멀티모달AI, 이미지검색, 영상분석, 자연어처리, 트랜스포머, 비전트랜스포머, ResNet, 임베딩, ZeroShotLearning, ContrastiveLearning, MultimodalLearning, ImageRecognition, ComputerVision, MachineLearning, DeepLearning, HuggingFace, GoogleColab, Python, 코드, 튜토리얼, 활용, 사례, 장점, 단점, 미래, 전망, 기술, 발전, 연구, 논문, SOTA, ImageNet, CIFAR100, OxfordIIITPets, 데이터셋, 성능, 비교, FAQ, 자주묻는질문