사전 학습된 거대 언어 모델을 활용하면서도, 제한된 자원으로 최고의 성능을 뽑아내고 싶으신가요? LoRA (Low-Rank Adaptation)는 바로 그 꿈을 현실로 만들어줄 핵심 기술입니다. 방대한 파라미터를 가진 거대 언어 모델을 그대로 학습시키지 않고, 모델 파라미터의 일부만을 재구성하여 효율적으로 파인튜닝하는 LoRA의 매력 속으로 빠져볼까요?

LoRA: 모델 파라미터의 효율적인 재구성

LoRA는 Low-Rank Adaptation의 약자로, 말 그대로 대규모 모델을 파인튜닝할 때 필요한 파라미터를 최소화하면서도 뛰어난 성능을 유지하는 기술이에요. 쉽게 말해, 기존 모델의 모든 파라미터를 건드리지 않고, 몇몇 파라미터만 새롭게 학습해서 모델을 개선하는 방식이라고 생각하면 돼요.

LoRA의 핵심 아이디어: 저차원 행렬을 이용한 변환

LoRA의 핵심은 기존 모델의 파라미터 행렬을 저차원 행렬(Low-Rank Matrices)로 분해하고, 이 분해된 행렬을 학습하는 데 있어요. 마치 복잡한 그림을 몇 개의 간단한 도형으로 분해해서 표현하는 것과 비슷하다고 생각하면 이해가 쉬울 거예요.

기존 모델의 파라미터 행렬을 W라고 하면, LoRA에서는 W를 W0 + BA와 같이 두 개의 작은 행렬 A, B의 곱으로 표현해요. W0는 사전에 학습된 기존 모델의 파라미터 행렬이고, A, B는 LoRA에서 새롭게 학습하는 행렬이에요.

W = W0 + BA

이렇게 작은 행렬 A, B를 학습함으로써, 기존 모델의 아키텍처를 변경하지 않고도 원하는 작업에 맞춰 모델을 효율적으로 개선할 수 있답니다. 이 과정에서 학습해야 하는 파라미터 수가 기존 방식에 비해 훨씬 적기 때문에, 계산 비용과 메모리 사용량을 크게 줄일 수 있는 거죠.

LoRA의 장점: 리소스 효율성과 성능 향상의 조화

LoRA를 사용하면, 여러 가지 장점을 얻을 수 있어요.

- 리소스 효율성 향상: 기존 모델의 파라미터를 건드리지 않고 추가 파라미터만 학습하기 때문에, GPU 메모리 사용량과 연산량이 줄어들어요. 덕분에 훨씬 적은 자원으로도 모델을 파인튜닝할 수 있답니다.

- 다양한 작업에 손쉬운 적용: 각 작업마다 다른 LoRA 레이어를 사용할 수 있어요. 마치 레고 블록을 조립하듯, 필요에 따라 모델을 쉽게 바꿔가면서 사용할 수 있답니다.

- 추론 속도 유지: LoRA는 행렬 연산을 기반으로 하기 때문에, 기존 모델의 추론 속도를 그대로 유지할 수 있어요. 즉, 파인튜닝 후에도 모델의 응답 속도가 느려지지 않는다는 뜻이죠!

LoRA의 활용: 다양한 분야에서 빛을 발하는 LoRA

LoRA는 다양한 분야에서 널리 활용되고 있어요. 특히, 대규모 언어 모델의 파인튜닝에 유용하게 쓰이는데, LLaMA 모델의 변형인 Alpaca 프로젝트에서도 LoRA가 적용되어 있어요. 또한, Hugging Face의 PEFT 라이브러리에서 LoRA를 쉽게 사용할 수 있도록 구현되어 있기 때문에, 누구나 간편하게 활용할 수 있다는 장점이 있답니다.

LoRA 적용 사례: 실제로 어떻게 활용될까요?

- 챗봇 개발: 특정 분야에 특화된 챗봇을 만들 때, 기존의 대규모 언어 모델을 LoRA를 활용해 파인튜닝하면, 해당 분야의 지식을 갖춘 챗봇을 효율적으로 개발할 수 있어요.

- 텍스트 요약: 긴 문서를 요약하는 작업에 LoRA를 활용하면, 문서의 핵심 내용을 추출하는 데 특화된 모델을 만들 수 있답니다.

- 번역 모델 개선: LoRA를 통해 특정 언어 쌍의 번역 성능을 높이는 데 활용할 수 있어요.

LoRA와 함께하는 파인튜닝: 실제 적용 방법

LoRA를 사용하여 모델을 파인튜닝하는 방법은 생각보다 간단해요. Hugging Face의 PEFT 라이브러리와 같은 도구를 활용하면 쉽게 LoRA를 적용할 수 있어요.

LoRA 파인튜닝 단계: 간단한 4단계

- 사전 학습된 모델 준비: 먼저 파인튜닝할 기반 모델을 준비해야 해요. 예를 들어, GPT-2, LLaMA와 같은 모델을 사용할 수 있답니다.

- LoRA 레이어 삽입: PEFT 라이브러리를 사용하여 기존 모델에 LoRA 레이어를 삽입해요.

- 파인튜닝 데이터셋 준비: 파인튜닝에 사용할 데이터셋을 준비해요. 목표 작업에 맞는 데이터를 사용하는 것이 중요하겠죠?

- 파인튜닝 실행: 준비된 데이터셋을 이용하여 LoRA 레이어를 학습시켜요.

LoRA 파인튜닝 코드 예시: 간단한 코드로 LoRA 경험하기

from transformers import AutoModelForSequenceClassification, TrainingArguments, Trainer

from peft import LoraConfig, get_peft_model

model = AutoModelForSequenceClassification.from_pretrained("bert-base-uncased")

lora_config = LoraConfig(

r=8, # Rank of the LoRA matrix

lora_alpha=32, # Scaling factor for the LoRA matrices

target_modules=["query", "value"], # Modules to apply LoRA to

lora_dropout=0.1, # Dropout rate for the LoRA matrices

bias="none", # Whether to train biases

task_type="SEQ_CLS" # Type of task for the model

)

model = get_peft_model(model, lora_config)

training_args = TrainingArguments(

output_dir="./results",

per_device_train_batch_size=16,

gradient_accumulation_steps=4,

num_train_epochs=3,

logging_dir="./logs"

)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=train_dataset,

eval_dataset=eval_dataset

)

trainer.train()코드에서 는 LoRA의 설정 값을 지정해요. , , 와 같은 설정 값을 변경하여 LoRA를 조정할 수 있답니다.

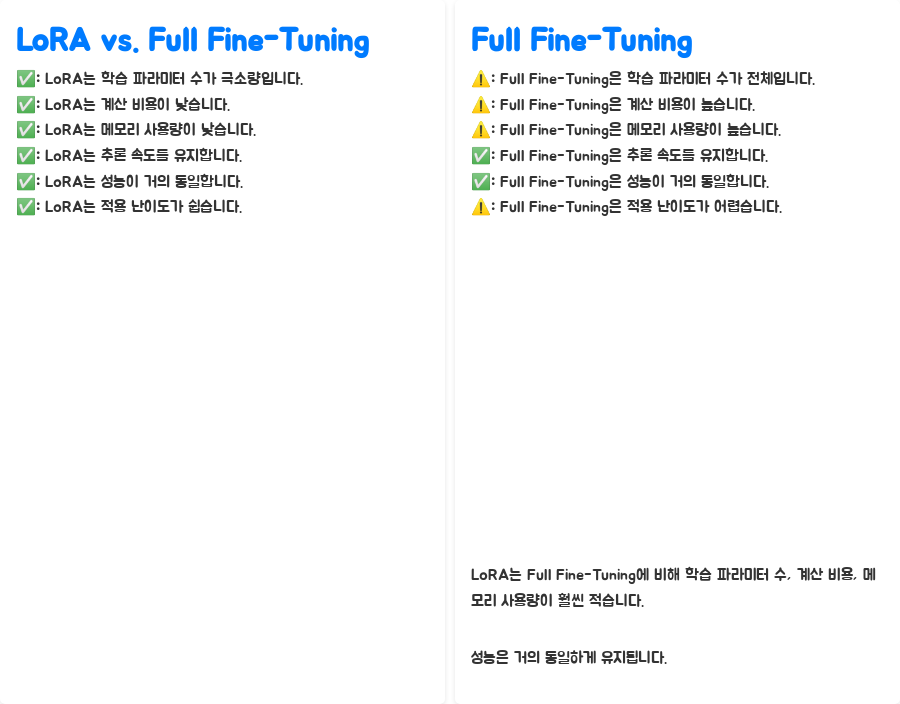

LoRA vs. Full Fine-Tuning: 어떤 차이가 있을까요?

| 학습 파라미터 수 | 극소량 | 전체 |

| 계산 비용 | 낮음 | 높음 |

| 메모리 사용량 | 낮음 | 높음 |

| 추론 속도 | 유지 | 유지 |

| 성능 | 거의 동일 | 거의 동일 |

| 적용 난이도 | 쉬움 | 어려움 |

특징 LoRA Full Fine-Tuning

표에서 보시다시피, LoRA는 Full Fine-Tuning에 비해 학습 파라미터 수, 계산 비용, 메모리 사용량이 훨씬 적어요. 하지만, 성능은 거의 동일하게 유지한다는 사실이 놀랍죠?

마무리: LoRA, 효율적인 파인튜닝의 미래를 열다

LoRA는 대규모 언어 모델의 파인튜닝을 효율적으로 수행할 수 있는 혁신적인 기술이에요. 제한된 자원으로도 뛰어난 성능을 얻고 싶다면, LoRA를 적극 활용해보세요. LoRA를 통해 인공지능 모델의 가능성을 더욱 넓혀나가 보시길 바랍니다!

QnA: 궁금한 점을 해소해 드릴게요

Q1. LoRA는 어떤 모델에 적용할 수 있나요?

A1. LoRA는 Transformer 아키텍처를 기반으로 하는 다양한 모델에 적용할 수 있어요. GPT, BERT, LLaMA 등의 대규모 언어 모델뿐만 아니라, 이미지 인식 모델이나 음성 인식 모델에도 적용 가능하답니다.

Q2. LoRA를 사용하면 Full Fine-Tuning에 비해 성능이 떨어지나요?

A2. LoRA는 Full Fine-Tuning과 비슷한 수준의 성능을 제공해요. 실제로 많은 연구에서 LoRA를 사용했을 때 Full Fine-Tuning과 거의 동일한 성능을 달성했다는 결과가 보고되었어요.

Q3. LoRA를 사용하면 어떤 점이 가장 큰 장점일까요?

A3. LoRA의 가장 큰 장점은 리소스 효율성이에요. 기존 모델의 파라미터를 건드리지 않고 추가 파라미터만 학습하기 때문에, GPU 메모리 사용량과 연산량이 크게 줄어들어요. 덕분에 훨씬 적은 자원으로도 모델을 파인튜닝할 수 있답니다.

LoRA, LowRankAdaptation, 파인튜닝, FineTuning, ParameterEfficientFineTuning, PEFT, 대규모언어모델, LLM, 효율성, 자원절약, 머신러닝, 딥러닝, 인공지능, AI, HuggingFace, PEFT라이브러리, 트랜스포머, Transformer, Alpaca, LLaMA, GPT, BERT, 자연어처리, NLP, 챗봇, 텍스트요약, 번역, 모델최적화, 딥러닝모델, AI모델, 머신러닝모델, 데이터과학, 데이터사이언스, AI개발, 머신러닝개발, 딥러닝개발, AI트렌드, 기술블로그, IT블로그, techblog, AI기술, 딥러닝기술, 머신러닝기술